Der grösste Fehler bei der Einführung von KI und IoT ist die Konzentration auf die Technologie selbst statt auf das zu lösende Problem.

- Erfolgreiche Projekte starten nicht mit einem Tool, sondern mit einem klar definierten operativen Engpass.

- Die Aufgabe eines CTOs ist es, den richtigen „Technologie-Problem-Fit“ zu finden: die eine Technologie, die ein spezifisches Problem am effektivsten löst.

Empfehlung: Analysieren Sie zuerst Ihre operativen Wertschöpfungsketten und Datenfundamente, bevor Sie eine Technologie-Roadmap für KI oder IoT erstellen.

Als Chief Technology Officer stehen Sie unter einem doppelten Druck: Einerseits sollen Sie bahnbrechende Innovationen vorantreiben und Schlagworte wie Künstliche Intelligenz (KI) und das Internet der Dinge (IoT) mit Leben füllen. Andererseits müssen Sie den reibungslosen Betrieb sicherstellen, der oft auf über Jahre gewachsenen, komplexen Legacy-Systemen beruht. Die Versuchung ist gross, Leuchtturmprojekte zu starten, um Innovationsfähigkeit zu demonstrieren. Man hört oft Ratschläge wie „Fangen Sie klein an“ oder „Sammeln Sie einfach Daten“. Doch diese Ansätze führen häufig in die Irre, da sie die wichtigste Frage ignorieren.

Die wahre Herausforderung liegt nicht darin, *ob* man KI oder IoT einsetzt, sondern *wofür*. Viele Projekte scheitern nicht an der Technologie, sondern daran, dass sie kein relevantes Geschäftsproblem lösen. Sie werden zu teuren Experimenten, deren Ergebnisse in der Schublade verschwinden, weil sie keinen messbaren Beitrag zur operativen Wertschöpfung leisten. Die entscheidende Verschiebung der Denkweise, die wir in diesem Artikel verfolgen, ist der Problem-First-Ansatz. Statt zu fragen: „Was können wir mit KI machen?“, lautet die strategische Frage: „Welches unserer dringendsten operativen Probleme – sei es in der Produktion, im Kundenservice oder im Risikomanagement – lässt sich durch eine spezifische Technologie am wirksamsten und nachhaltigsten lösen?“

Dieser Leitfaden ist für Sie als Technologie-Scout konzipiert. Er liefert keine erschöpfende Liste von Tools, sondern ein strategisches Framework. Wir werden konkrete Anwendungsfälle analysieren, um zu verstehen, wann eine Technologie wie KI, IoT, Blockchain oder VR die richtige Antwort ist – und wann nicht. Ziel ist es, Ihnen eine Methode an die Hand zu geben, um Hype von echter Substanz zu trennen und Investitionen in Technologie zu tätigen, die direkt auf die Unternehmensziele einzahlen.

Um Ihnen eine klare Orientierung zu geben, gliedert sich dieser Artikel in spezifische Problemstellungen. Jede Sektion beleuchtet eine typische Herausforderung und zeigt auf, wie ein gezielter Technologieeinsatz eine pragmatische Lösung bieten kann. So navigieren Sie sicher durch den Dschungel der Möglichkeiten.

Inhalt: KI und IoT strategisch einsetzen – ein Leitfaden für CTOs

- Darf eine KI entscheiden, wer einen Kredit bekommt, und wie erklären Sie das dem Kunden?

- Wie verhindern Sie den Maschinenausfall, bevor das Bauteil bricht?

- Wann hilft die Blockchain wirklich gegen Fälschungen und wann ist sie nur teure Datenbank?

- Wie trainieren Sie gefährliche Handgriffe sicher und billiger in der virtuellen Realität?

- Welche neuen Einfallstore für Hacker öffnet die Vernetzung Ihrer Fabrik?

- Warum übersehen Marktführer oft die Gefahr von unten (Innovator’s Dilemma)?

- Warum scheitern KI-Projekte oft an fehlenden Basis-Datenstrukturen?

- Wie modernisieren Sie Ihre IT-Landschaft, ohne den laufenden Betrieb zu gefährden?

Darf eine KI entscheiden, wer einen Kredit bekommt, und wie erklären Sie das dem Kunden?

Die automatisierte Kreditentscheidung durch KI ist ein Paradebeispiel für den Einsatz von Technologie zur Effizienzsteigerung. Das Kernproblem ist hier die Abwägung zwischen Geschwindigkeit, Genauigkeit und regulatorischen Anforderungen. Traditionelle Prozesse sind langsam und personalintensiv. Eine KI kann tausende Datenpunkte in Sekunden analysieren und so schnellere sowie potenziell präzisere Risikobewertungen liefern. Doch die grösste Hürde ist nicht technischer, sondern ethischer und kommunikativer Natur: die sogenannte „Black Box“. Wenn selbst die Entwickler nicht vollständig nachvollziehen können, warum ein Algorithmus eine bestimmte Entscheidung getroffen hat, wie soll man dies einem abgelehnten Kunden oder einer Aufsichtsbehörde erklären?

Die Lösung liegt im Konzept der Erklärbarkeit (Explainable AI, XAI). Statt undurchsichtiger Modelle setzen führende Unternehmen auf Systeme, die ihre Entscheidungswege transparent machen können. Sie zeigen auf, welche Faktoren (z.B. Zahlungshistorie, Branchentrends, saisonale Schwankungen) wie stark in die Bewertung eingeflossen sind. Dies schafft nicht nur die notwendige Compliance, sondern auch Vertrauen beim Kunden. Der Fokus verschiebt sich von einer reinen Automatisierung hin zu einer augmentierten Intelligenz, bei der die KI den menschlichen Entscheider mit fundierten, nachvollziehbaren Empfehlungen unterstützt.

Fallstudie: Banca AideXa und KI-basierte KMU-Kredite

Ein Praxisbeispiel aus Italien zeigt, wie das gelingen kann, wie eine Fallstudie über die Banca AideXa veranschaulicht: Die Bank nutzt KI-Analysemodelle für die Kreditvergabe an kleine und mittlere Unternehmen (KMU). Anstatt sich nur auf Geschäftsberichte zu verlassen, werden tausende Datenpunkte für jeden Antrag analysiert. Antragsteller erhalten innerhalb von 20 Minuten eine Antwort, und bei positivem Bescheid wird das Geld binnen 48 Stunden überwiesen. Trotz dieser Geschwindigkeit liegt die Ausfallrate mit nur 3,4 Prozent weit unter dem Branchendurchschnitt traditioneller Institute, was die Präzision des KI-Modells unterstreicht.

Die Zukunft liegt in der nachweisbaren Fairness und Transparenz, wie Experten betonen.

Vertrauen muss verdient werden. 2026 wird es von einem Versprechen zu einer unbestechlichen Performance-Metrik, denn der Fokus von Banken entwickelt sich von Modell-getriebener hin zu Nachweis-getriebener Intelligenz. Der neue Standard für diese Intelligenz ist verifizierbare Transparenz für jede Prognose, jede Entscheidung und jede Interaktion.

– Alex Kwiatkowski, Director of Financial Services Marketing bei SAS

Für Sie als CTO bedeutet das: Priorisieren Sie bei KI-Projekten in regulierten Bereichen nicht die leistungsstärksten, sondern die transparentesten Modelle. Die Fähigkeit, eine Entscheidung zu erklären, wird zum entscheidenden Wettbewerbsvorteil.

Wie verhindern Sie den Maschinenausfall, bevor das Bauteil bricht?

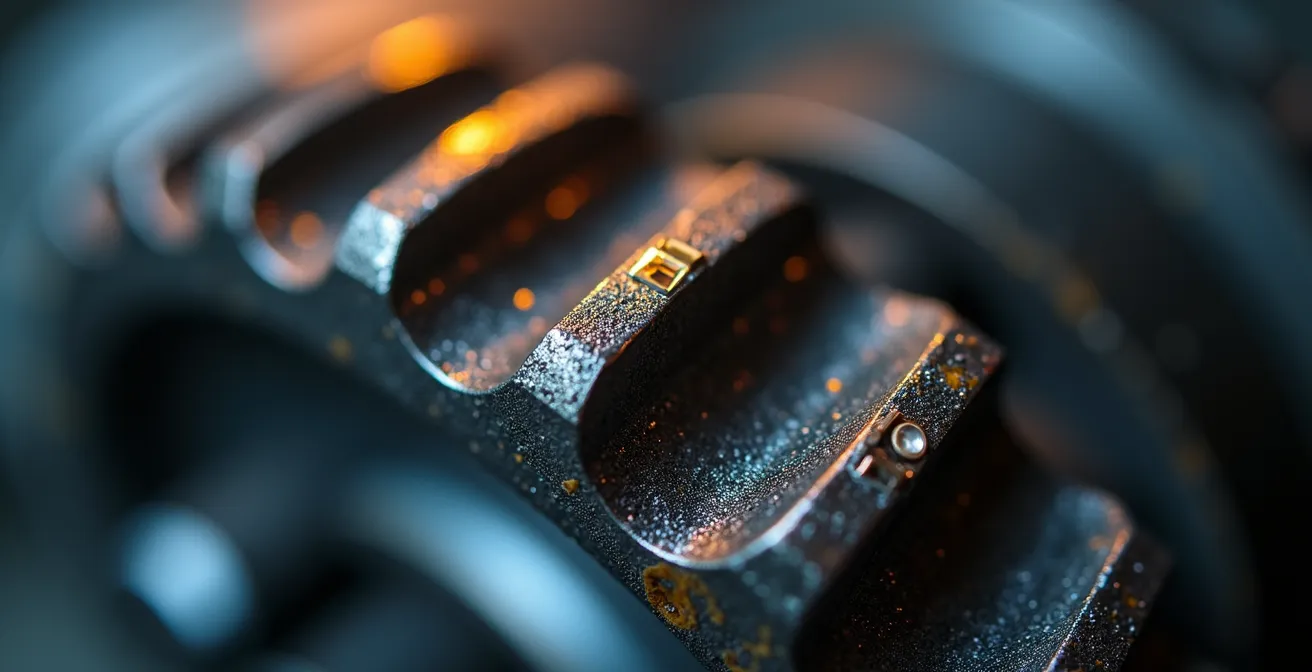

In der industriellen Fertigung ist ungeplante Stillstandszeit der grösste Feind der Produktivität. Das Problem ist reaktiver Natur: Eine Maschine fällt aus, die Produktion stoppt, und teure Techniker müssen den Fehler unter Zeitdruck beheben. Die Lösung, die IoT und KI hier bieten, ist der Wandel von reaktiver zu prädiktiver und sogar präskriptiver Wartung. Das Prinzip ist einfach: IoT-Sensoren an kritischen Maschinenkomponenten – wie Lagern, Motoren oder Pumpen – sammeln kontinuierlich Daten über Vibrationen, Temperaturen oder Geräuschemissionen.

Diese Datenströme allein sind jedoch wertlos. Erst eine KI-Analyseplattform kann darin Muster erkennen, die auf einen bevorstehenden Ausfall hindeuten. Dies ist die Predictive Maintenance: Das System sagt voraus, dass ein Bauteil in den nächsten 72 Stunden wahrscheinlich ausfallen wird. Der nächste Schritt ist die Prescriptive Maintenance: Das System gibt eine konkrete Handlungsempfehlung. Es schlägt nicht nur vor, das Bauteil zu ersetzen, sondern empfiehlt auch den optimalen Zeitpunkt dafür (z.B. während der nächsten geplanten Wartungspause) und bestellt das Ersatzteil automatisch.

Der wirtschaftliche Nutzen ist enorm. McKinsey-Analysen zeigen, dass Unternehmen durch diesen Ansatz ihre Wartungskosten um bis zu 40 % senken und Ausfallzeiten um bis zu 50 % reduzieren können. Der Schlüssel zum Erfolg liegt darin, klein anzufangen. Identifizieren Sie die kritischsten Maschinen in Ihrer Produktionslinie – jene, deren Ausfall die grössten Folgekosten verursacht – und statten Sie diese gezielt mit Sensorik aus. So schaffen Sie einen messbaren Business Case, der die Skalierung auf die gesamte Fabrik rechtfertigt.

Die Investition in IoT-Plattformen und KI-Analytik ist somit keine reine Technologie-Spielerei, sondern eine direkte Investition in die Resilienz und Effizienz Ihrer operativen Prozesse.

Wann hilft die Blockchain wirklich gegen Fälschungen und wann ist sie nur teure Datenbank?

Blockchain ist eine der am meisten gehypten und gleichzeitig am meisten missverstandenen Technologien. Oft wird sie als Allheilmittel für Transparenz und Sicherheit angepriesen. Doch auch hier gilt der Problem-First-Ansatz. Die Blockchain ist im Kern eine spezielle Form einer dezentralen, unveränderlichen Datenbank (Distributed Ledger Technology, DLT). Ihre Stärke liegt nicht in der Datenspeicherung selbst, sondern in der fälschungssicheren Protokollierung von Transaktionen zwischen mehreren Parteien, die sich nicht zwangsläufig vertrauen.

Das Kernproblem, das die Blockchain effektiv löst, ist daher die Sicherstellung der Integrität und Nachverfolgbarkeit in einem dezentralen Netzwerk. Ein klassisches Beispiel ist die Lieferkettenverfolgung für Luxusgüter oder Pharmazeutika. Jede Übergabe eines Produkts – vom Hersteller zum Logistiker, zum Zoll, zum Händler – wird als Transaktion auf der Blockchain fälschungssicher vermerkt. Ein Endkunde kann dann per QR-Code die gesamte Historie des Produkts lückenlos zurückverfolgen und dessen Echtheit verifizieren. Die Technologie schafft hier Vertrauen, wo es vorher keines gab.

Allerdings ist die Blockchain in vielen Fällen die falsche Lösung. Wenn alle beteiligten Akteure innerhalb eines einzigen, vertrauenswürdigen Unternehmens agieren (z.B. bei der internen Dokumentenverwaltung), ist eine zentrale, traditionelle Datenbank weitaus effizienter, schneller und kostengünstiger. Die Blockchain wird zur „teuren Datenbank“, wenn ihre Kernfunktion – die Schaffung von Vertrauen zwischen misstrauischen Parteien – nicht benötigt wird. Man spricht hier vom „Blockchain-Trilemma“: Es ist extrem schwierig, gleichzeitig Dezentralisierung, Sicherheit und Skalierbarkeit zu erreichen. Oft geht die hohe Sicherheit und Dezentralität auf Kosten der Geschwindigkeit.

Als CTO sollten Sie daher immer fragen: Gibt es mehrere, unabhängige Parteien? Ist das Misstrauen zwischen ihnen das eigentliche Problem? Ist Unveränderlichkeit der Daten entscheidend? Nur wenn Sie alle drei Fragen mit „Ja“ beantworten, ist die Blockchain eine ernsthafte Option.

Wie trainieren Sie gefährliche Handgriffe sicher und billiger in der virtuellen Realität?

In vielen Industrien, von der Chirurgie über die Luftfahrt bis hin zur Wartung von Hochspannungsanlagen, ist das Training von Mitarbeitern ein Dilemma. Das Problem: Reale Trainingsszenarien sind entweder extrem gefährlich, unvorstellbar teuer oder schlicht nicht reproduzierbar. Wie trainiert ein Techniker die Reparatur einer Windkraftanlage in 100 Metern Höhe bei Sturm? Wie übt ein Chirurg einen seltenen, komplexen Eingriff, ohne einen Patienten zu gefährden?

Hier bieten Virtual Reality (VR) und Augmented Reality (AR) eine pragmatische und hochwirksame Lösung. Mittels VR können Mitarbeiter in eine vollständig immersive, digitale Simulation einer realen Umgebung versetzt werden. Dort können sie komplexe und gefährliche Handgriffe beliebig oft wiederholen, bis jeder Schritt sitzt – ohne jedes Risiko und zu einem Bruchteil der Kosten eines realen Trainings. Fehler in der Simulation haben keine Konsequenzen, bieten aber wertvolle Lerneffekte. Studien zeigen, dass die Wissensaufnahme und -erhaltung in VR-Trainings signifikant höher ist als bei traditionellen Methoden, da das Gehirn durch die immersive Erfahrung stärker aktiviert wird.

Augmented Reality geht einen Schritt weiter und überlagert die reale Welt mit digitalen Informationen. Ein Techniker, der eine komplexe Maschine wartet, kann durch seine AR-Brille digitale Anweisungen, Schaltpläne oder Markierungen direkt auf dem realen Bauteil sehen. Dies reduziert die Fehlerquote drastisch und verkürzt die Einarbeitungszeit neuer Mitarbeiter erheblich. AR dient hier als kognitives Werkzeug, das menschliche Fähigkeiten erweitert, anstatt sie zu ersetzen.

Für Sie als CTO ist der Anwendungsfall klar: Identifizieren Sie die teuersten, gefährlichsten oder wissensintensivsten manuellen Prozesse in Ihrem Unternehmen. VR/AR-Trainings bieten hier einen schnellen und messbaren Return on Investment durch reduzierte Trainingskosten, geringere Unfallraten und gesteigerte Prozessqualität.

Welche neuen Einfallstore für Hacker öffnet die Vernetzung Ihrer Fabrik?

Die fortschreitende Vernetzung von Produktionsanlagen (Operational Technology, OT) mit der IT-Welt durch das Industrial Internet of Things (IIoT) schafft enorme Effizienzgewinne. Gleichzeitig öffnet sie aber auch ein riesiges neues Einfallstor für Cyberangriffe. Das Problem ist die Konvergenz zweier Welten, die historisch getrennt waren. IT-Sicherheit konzentriert sich auf den Schutz von Daten (Vertraulichkeit, Integrität, Verfügbarkeit). OT-Sicherheit hingegen hat die physische Sicherheit und den ununterbrochenen Betrieb von Maschinen als oberste Priorität.

Ein Angriff auf ein OT-System zielt nicht primär auf Datendiebstahl, sondern auf die Sabotage physischer Prozesse. Hacker könnten Produktionsparameter manipulieren, um Ausschuss zu produzieren, Sicherheitsprotokolle von Maschinen ausser Kraft setzen, um Unfälle zu verursachen, oder eine ganze Fabrikhalle lahmlegen. Die Angriffsfläche ist riesig: von ungesicherten Sensoren über veraltete Steuerungssysteme (SPS), die nie für eine Verbindung mit dem Internet gedacht waren, bis hin zu Wartungs-Laptops von Drittanbietern, die mit Malware infiziert sind. Der traditionelle Ansatz, die Fabrik als abgeschottete „Insel“ zu betrachten, funktioniert in der Ära von Industrie 4.0 nicht mehr.

Die Lösung erfordert eine integrierte IT/OT-Sicherheitsstrategie. Dies umfasst mehrere Ebenen:

- Netzwerksegmentierung: Strikte Trennung von IT- und OT-Netzwerken, sodass ein Einbruch ins Büronetzwerk nicht automatisch den Zugriff auf die Maschinensteuerung ermöglicht.

- Asset-Inventarisierung: Sie können nur schützen, was Sie kennen. Eine lückenlose Erfassung aller vernetzten Geräte in der Produktion ist die Grundvoraussetzung.

- Monitoring und Anomalieerkennung: Spezielle Sicherheitssysteme für OT-Netzwerke analysieren den Datenverkehr und schlagen Alarm, wenn ungewöhnliche Kommunikationsmuster auftreten (z.B. wenn eine Steuerungseinheit plötzlich versucht, mit einem Server in einem fremden Land zu kommunizieren).

- Security by Design: Bei der Anschaffung neuer Maschinen und Anlagen müssen Cybersicherheitsanforderungen von Anfang an Teil des Lastenhefts sein.

Als CTO müssen Sie die Brücke zwischen den IT- und OT-Teams bauen. Die Verantwortung für die Sicherheit endet nicht mehr am Fabriktor. Eine robuste IIoT-Strategie ist untrennbar mit einer ebenso robusten Cybersicherheitsstrategie verbunden.

Warum übersehen Marktführer oft die Gefahr von unten (Innovator’s Dilemma)?

Das „Innovator’s Dilemma“, ein von Clayton Christensen geprägter Begriff, beschreibt ein Paradoxon, das gerade für Sie als CTO in einem etablierten Unternehmen von höchster Relevanz ist. Das Problem: Marktführer scheitern oft nicht, weil sie schlechte Entscheidungen treffen, sondern weil sie *gute* Entscheidungen treffen – basierend auf den Bedürfnissen ihrer aktuellen, profitabelsten Kunden. Sie investieren in inkrementelle Verbesserungen (sogenannte erhaltende Innovationen) ihrer bestehenden Produkte, weil ihre besten Kunden genau das verlangen und dafür bezahlen.

Währenddessen entstehen in Nischenmärkten disruptive Innovationen. Diese sind anfangs oft technologisch unterlegen, einfacher und billiger. Sie sprechen ein kleines, unbedeutendes Kundensegment an, das für den Marktführer uninteressant ist. Ein klassisches Beispiel ist der Übergang von Mainframe-Computern zu Personal Computern. Etablierte Hersteller ignorierten den PC, weil ihre Grosskunden ihn als Spielzeug abtaten. Doch die Technologie entwickelte sich rasant weiter und eroberte schliesslich den gesamten Markt von unten.

Für Sie als CTO bedeutet dies eine ständige Gratwanderung. Ihr Hauptgeschäft finanziert das Unternehmen, aber die nächste Wachstums- oder Bedrohungswelle kommt wahrscheinlich nicht aus diesem Kerngeschäft. Die Gefahr ist, dass der Fokus auf die Optimierung der Legacy-Systeme und die Erfüllung der Wünsche von Bestandskunden den Blick auf die disruptiven Technologien verstellt, die am Horizont auftauchen. Diese werden oft als „nicht industrietauglich“ oder „unprofitabel“ abgetan, bis es zu spät ist.

Ihre Aufgabe ist es, geschützte Räume oder „Skunk Works“-Teams zu schaffen, die unabhängig vom Kerngeschäft an diesen disruptiven Technologien arbeiten dürfen. Sie müssen Budgets für Projekte rechtfertigen, deren unmittelbarer ROI nicht klar ist, die aber als strategische Wette auf die Zukunft dienen. Es geht darum, das eigene Geschäftsmodell gezielt zu kannibalisieren, bevor es ein anderer tut.

Warum scheitern KI-Projekte oft an fehlenden Basis-Datenstrukturen?

Viele Unternehmen starten euphorisch in KI-Projekte, nur um nach Monaten festzustellen, dass sie auf der Stelle treten. Der Grund ist oft unspektakulär, aber fundamental: Die Daten sind nicht da, nicht zugänglich oder von ungenügender Qualität. Das Problem ist, dass KI-Modelle, insbesondere im Bereich des maschinellen Lernens, auf grossen Mengen sauberer, gut strukturierter und korrekt gelabelter Daten trainiert werden müssen. Fehlt dieses Fundament, ist selbst der ausgeklügeltste Algorithmus nutzlos.

In vielen Unternehmen mit gewachsenen IT-Landschaften sind die Daten in isolierten Silos gefangen. Die Vertriebsdaten liegen in einem CRM-System, Produktionsdaten in einer MES-Software und Finanzdaten in einem ERP-System – oft ohne standardisierte Schnittstellen oder ein einheitliches Datenmodell. Bevor ein KI-Projekt auch nur beginnen kann, müssen riesige Aufwände in die Datenintegration, -bereinigung und -transformation gesteckt werden. Diese „unsexy“ Vorarbeit macht oft 80% eines KI-Projekts aus, wird aber bei der Planung häufig unterschätzt.

Ein weiteres Kernproblem ist die mangelnde Datenkultur. Wenn Daten als reines Nebenprodukt operativer Prozesse und nicht als strategisches Asset betrachtet werden, leidet die Qualität. Es fehlen Metadaten, die den Kontext der Daten erklären, es gibt keine klaren Verantwortlichkeiten für die Datenqualität (Data Governance), und es existiert kein zentraler „Single Source of Truth“. Ein KI-Modell, das mit inkonsistenten oder fehlerhaften Daten trainiert wird, wird unweigerlich falsche und potenziell schädliche Vorhersagen treffen („Garbage In, Garbage Out“).

Als CTO lautet Ihre erste Aufgabe bei jeder KI-Initiative daher nicht, einen Data Scientist einzustellen, sondern eine schonungslose Bestandsaufnahme Ihrer Datenlandschaft durchzuführen. Investieren Sie in eine moderne Datenplattform, in APIs zur Anbindung der Silos und in klare Data-Governance-Prozesse. Der Aufbau eines soliden Datenfundaments ist die wichtigste und nachhaltigste Investition in die Zukunftsfähigkeit Ihres Unternehmens.

Das Wichtigste in Kürze

- Technologie ist ein Werkzeug, kein Ziel. Beginnen Sie mit dem operativen Problem, nicht mit der Technologie.

- Der wahre Wert von KI und IoT liegt in der Lösung konkreter Engpässe: Risikominimierung, Effizienzsteigerung, Kostensenkung oder Sicherheitsverbesserung.

- Ein solides Datenfundament ist die nicht verhandelbare Voraussetzung für fast alle erfolgreichen KI-Projekte. Daten-Silos und mangelnde Qualität sind die häufigsten Killer.

Wie modernisieren Sie Ihre IT-Landschaft, ohne den laufenden Betrieb zu gefährden?

Die Modernisierung einer über Jahre gewachsenen IT-Landschaft ist eine der grössten Herausforderungen für einen CTO. Das Problem ist vergleichbar mit einer Operation am offenen Herzen: Sie müssen kritische Systeme austauschen oder erneuern, während das Geschäft ununterbrochen weiterlaufen muss. Ein „Big Bang“-Ansatz, bei dem das gesamte System auf einmal ersetzt wird, ist in den meisten Fällen zu riskant und führt fast zwangsläufig zu katastrophalen Ausfällen. Der Schlüssel liegt in einer schrittweisen, strategischen und risikobewussten Vorgehensweise.

Ein bewährter Ansatz ist die Strangler Fig Pattern (Würgefeigen-Muster). Anstatt das monolithische Altsystem direkt anzugehen, bauen Sie neue Funktionalitäten als separate, moderne Microservices um den Monolithen herum. Jedes Mal, wenn eine neue Funktion benötigt oder eine alte modernisiert wird, wird sie nicht im Altsystem, sondern als neuer, unabhängiger Service implementiert. Eine Fassaden-Schicht (API Gateway) leitet Anfragen entweder an das neue Service oder an das alte System weiter. Über die Zeit „erwürgt“ das neue, flexible System das alte, bis der Monolith schliesslich abgeschaltet werden kann. Dieser Ansatz minimiert das Risiko und ermöglicht es, sofortigen Mehrwert zu schaffen.

Ein weiterer wichtiger Baustein ist eine robuste API-Strategie. APIs (Application Programming Interfaces) sind die Klebstoffe der modernen IT. Sie ermöglichen es, die in den alten Silos gefangenen Daten und Funktionen auf eine standardisierte Weise zugänglich zu machen, ohne die Altsysteme selbst verändern zu müssen. Dies erlaubt es neuen Anwendungen und Services, auf die bestehenden Daten zuzugreifen und schafft eine flexible Brücke zwischen der alten und der neuen Welt.

Ihr Aktionsplan zur Modernisierung der IT-Landschaft

- Inventarisierung & Priorisierung: Erfassen Sie alle bestehenden Systeme und bewerten Sie sie nach Geschäftskritikalität und technischem Zustand. Identifizieren Sie die Systeme, die den grössten „Schmerz“ verursachen oder die grösste Geschäftsbremse darstellen.

- Datenfundament schaffen: Definieren Sie eine „Single Source of Truth“ für kritische Stammdaten. Investieren Sie in eine zentrale Datenplattform und schaffen Sie über APIs Zugang zu den wichtigsten Datenquellen.

- Inseln der Innovation definieren: Wählen Sie einen überschaubaren, aber geschäftlich relevanten Bereich für ein erstes Modernisierungsprojekt (Pilot). Nutzen Sie hier den Strangler-Fig-Ansatz, um einen neuen Service zu entwickeln.

- Governance etablieren: Definieren Sie klare Standards für neue Entwicklungen (z.B. Cloud-native, API-first). Stellen Sie sicher, dass jedes neue Projekt diesen Standards folgt, um nicht die Legacy-Probleme von morgen zu schaffen.

- Kompetenzen aufbauen: Investieren Sie in die Schulung Ihrer Teams in modernen Technologien und agilen Methoden. Die beste Strategie scheitert ohne die Menschen, die sie umsetzen können.

Der erste Schritt zur Modernisierung ist nicht der grösste, sondern der klügste. Beginnen Sie mit einem Audit Ihrer Dateninfrastruktur und Ihrer geschäftskritischen Prozesse. Dies legt das Fundament für eine echte, wertschöpfende und zukunftssichere technologische Transformation.